Visão geral do produto¶

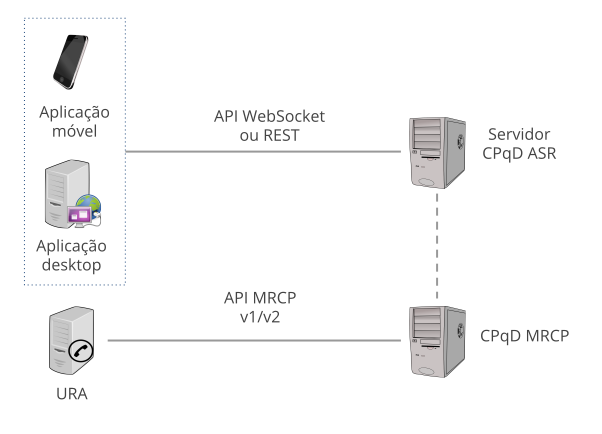

O CPqD ASR foi construído seguindo o paradigma cliente/servidor (Fig. 4), com uma camada que oferece as interfaces WebSocket e REST, que permitem que as aplicações do cliente tenham acesso aos recursos de reconhecimento de fala. Para aplicações de telefonia com URA, também pode ser usada a interface padronizada MRCP. Para facilitar o desenvolvimento de aplicações, são disponibilizadas algumas bibliotecas cliente que simplificam o processo de integração com o CPqD ASR.

Fig. 4 Integração com CPqD ASR.

O modelo acústico deve ser instalado no CPqD ASR de acordo com o idioma e a taxa de amostragem do áudio de entrada.

As gramáticas específicas para a aplicação podem ser criadas pelo próprio desenvolvedor, com a ajuda de ferramentas oferecidas pelo CPqD ASR. Se a aplicação utiliza as gramáticas builtin definidas na especificação, elas podem ser instaladas e usadas no reconhecimento.

Se a aplicação precisa reconhecer fala espontânea, um modelo para fala livre deve ser instalado de acordo com o idioma adotado. Normalmente, o modelo usado é de contexto geral, podendo ser usado em qualquer aplicação. Pode haver também modelos específicos para determinada área (médica, esportiva, etc.), mas eles devem ser aplicados ao contexto correspondente.